集成

连接任何 AI 工具到你的知识。自由切换,上下文不变。

Nowledge Mem 连接你今天用的工具,也连接你明天要换的新工具。知识留在一个地方,工具来去自由。

快速开始(一条命令)

适用于 Claude Code、Cursor、Codex、OpenCode、OpenClaw、Alma 等 20+ 个智能体:

npx skills add nowledge-co/community/nowledge-mem-npx-skills这将安装四个技能:search-memory、read-working-memory、save-thread 和 distill-memory。你的智能体每次会话开始时自带上下文,在需要时自动搜索知识,并在工作中保存重要发现。

| 我想要... | 使用 |

|---|---|

| 在 Claude Code、Codex、Cursor、OpenCode 或 Alma 中使用 Nowledge Mem | npx skills(如上)或工具专属设置 / Alma 插件 |

| 在 OpenClaw 中使用 Nowledge Mem | OpenClaw 插件 |

| 从 Raycast 搜索记忆 | Raycast 扩展 |

| 从 ChatGPT、Claude、Gemini 等 13+ AI 平台捕获记忆 | 浏览器扩展(自动或手动) |

| 通过互联网在任意机器访问 Mem | 随处访问 Mem 指南 |

| 构建自定义集成 | REST API 或 CLI |

模型上下文协议 (MCP)

MCP(模型上下文协议)是 AI 智能体与 Nowledge Mem 交互的集成方法。上面的 npx skills 底层使用 MCP。对于需要手动配置的工具,请继续阅读。

两种集成路径

| 路径 | 应用 | 设置 | 自主行为 |

|---|---|---|---|

| 技能兼容 | Claude Code, Codex, Cursor, OpenCode, OpenClaw, Alma | npx skills add 或安装插件 | 内置触发器,无需提示 |

| 仅 MCP | Claude Desktop, Cursor, ChatWise 等 | 配置 MCP + 系统提示 | 需要系统提示实现自主 |

选择哪个路径?

技能兼容应用(Claude Code, Codex, Cursor, OpenCode, OpenClaw, Alma):上面的 npx skills 命令最快。或跳转到 Claude Code / Codex CLI / Alma 了解工具专属设置。

仅 MCP 应用:继续阅读下文配置 MCP 并添加系统提示以实现自主行为。

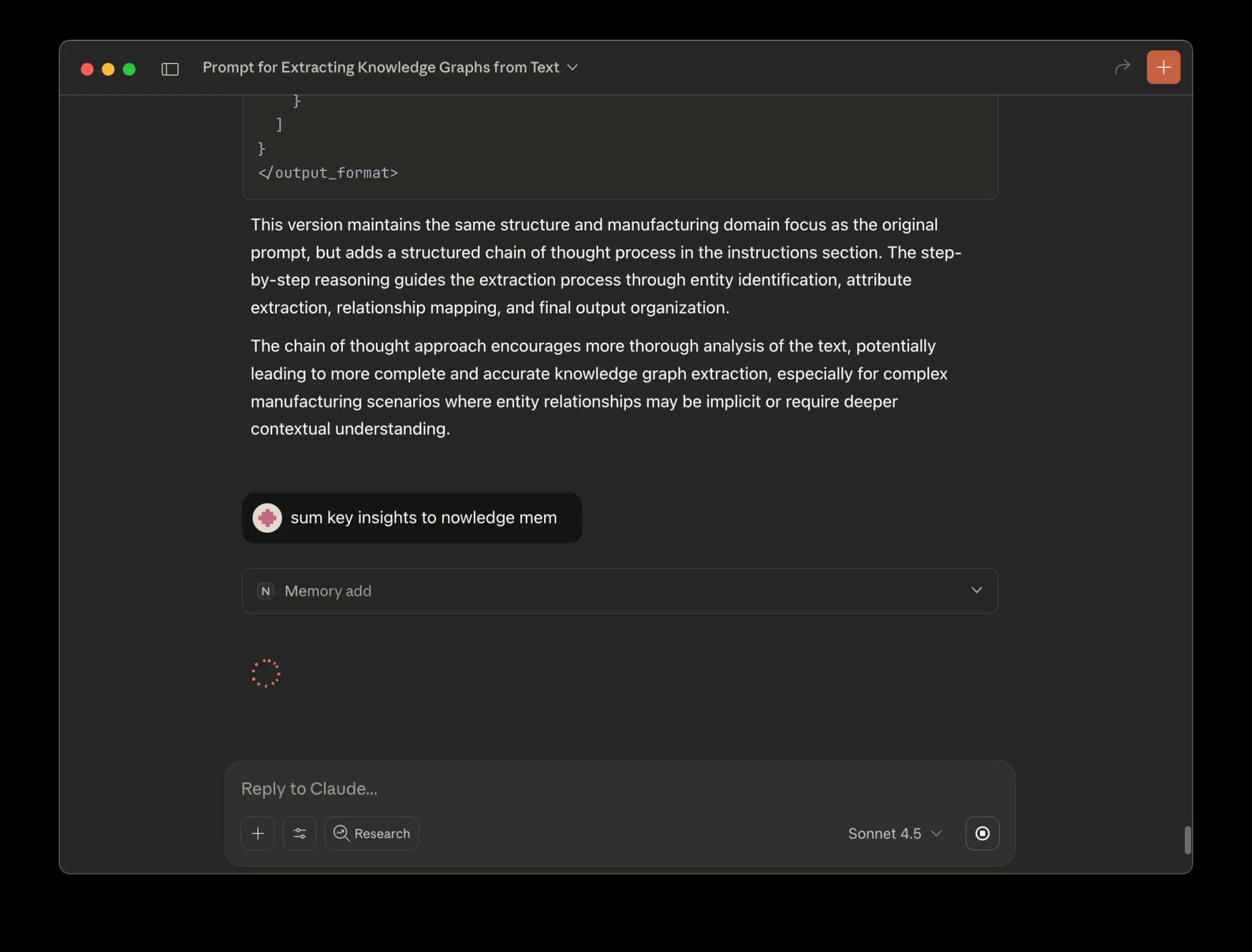

MCP 能力

- 搜索记忆:

memory_search - 读取 Working Memory:

read_working_memory - 添加记忆:

memory_add - 更新记忆:

memory_update - 列出记忆标签:

list_memory_labels - 保存/导入对话线程:

thread_persist - 提示:

sum(总结到记忆),save(保存对话线程)

MCP 服务器配置

ChatWise

ChatWise自主行为的系统提示

对于仅 MCP 应用要实现自主操作(无需显式命令),请将以下指令添加到智能体的系统提示或 CLAUDE.md/AGENTS.md 文件中:

## Nowledge Mem 集成

你可以使用 Nowledge Mem 进行知识管理。主动使用这些工具:

**会话开始时 (`read_working_memory`):**

- 读取 ~/ai-now/memory.md 获取今日简报

- 了解用户当前的关注领域、优先事项和未解决标记

- 在与当前任务相关时自然引用此上下文

**何时搜索 (`memory_search`):**

- 当前主题与先前工作相关

- 问题类似于过去解决的问题

- 用户询问之前的决策("我们为什么选择 X?")

- 复杂调试可能匹配过去的根本原因

**何时保存记忆 (`memory_add`):**

- 解决复杂问题或调试后

- 做出重要决策并附带理由时

- 发现关键洞察("啊哈"时刻)后

- 记录流程或工作流时

- 跳过:常规修复、进行中的工作、通用问答

**记忆类别(用作标签):**

- insight:关键学习、领悟

- decision:带有理由和权衡的选择

- fact:重要信息、数据点

- procedure:操作知识、工作流

- experience:事件、对话、结果

**记忆质量:**

- 原子性和可操作性(不模糊)

- 独立上下文(不需要对话即可理解)

- 关注"学到了什么"而非"讨论了什么"

**重要性等级(0.1-1.0):**

- 0.8-1.0:关键决策、突破

- 0.5-0.7:有用洞察、标准决策

- 0.1-0.4:背景信息、次要细节

**何时保存对话线程 (`thread_persist`):**

- 仅当用户明确请求时("保存此会话")

- 不要在未询问的情况下自动保存这可以在 Claude Desktop、Cursor 和 ChatWise 等应用中启用自主记忆操作。

浏览器扩展

Nowledge Mem Exchange 是一款浏览器扩展,从 AI 对话中捕获记忆。支持 ChatGPT、Claude、Gemini 等 13+ 个平台,在 Chrome 侧边栏中与对话并排运行。

三种捕获方式

| 模式 | 工作方式 | 适用场景 |

|---|---|---|

| 自动捕获 | 监控你的对话,自主保存有价值的洞察 | 设置后即可忘记。扩展决定什么值得记住 |

| 手动提炼 | 由你触发对特定对话的捕获 | 当你知道对话包含重要内容时 |

| 对话备份 | 将完整对话作为线程导入,支持增量去重 | 归档整个对话,稍后在应用中提炼 |

自动捕获

启用后,扩展监控 AI 对话并判断每次交互是否值得保存。筛选标准:

- 精炼的结论: 决策、计划、最终确定的方案

- 重要发现: 突破性进展、关键发现

- 知识探索: 深入研究、综合分析

日常问答和寒暄会被跳过。保存前会搜索现有记忆以去重,必要时更新已有记忆而非重新创建。

需要 LLM

自动捕获需要配置 LLM 提供商。打开侧边栏,进入设置,添加你的 API 密钥。支持的提供商:OpenAI、Anthropic、Google、xAI、OpenRouter、Ollama 以及 OpenAI 兼容端点。

对话备份

对话备份将完整对话作为线程导入。它跟踪已同步内容,后续备份只捕获新消息(增量同步)。导入后可在应用内触发提炼,提取独立记忆。

对于本地 AI 编程助手,Nowledge Mem 还支持 AI 对话发现(自动同步):可对 Claude Code、Cursor、Codex、OpenCode 做增量同步。

支持的平台

该扩展支持所有主流 AI 聊天服务:

| 平台 | 网站 |

|---|---|

| ChatGPT | openai.com, chatgpt.com |

| Claude | claude.ai |

| Gemini | gemini.google.com |

| Perplexity | perplexity.ai |

| DeepSeek | chat.deepseek.com |

| Kimi | kimi.moonshot.cn |

| 通义千问 | qwen.ai, tongyi.aliyun.com |

| POE | poe.com |

| Manus | manus.im |

| Grok | grok.com, grok.x.ai, x.ai |

| Open WebUI | localhost、私有 IP |

| ChatGLM | chatglm.cn |

| MiniMax | agent.minimaxi.com |

不支持的网站?

拥有已配置 LLM 的 Pro 用户可以为任何 AI 聊天网站自动生成处理器。导航到该网站,打开侧边栏,点击生成处理器。扩展会分析页面结构并自动创建自定义处理器。

让扩展接入「随处访问 Mem」

如果你已经在桌面端通过 设置 → 随处访问 Mem 暴露了 Mem API:

- 打开任意受支持的 AI 对话页面,并打开扩展侧边栏

- 点击 Settings

- 在 Access Mem Anywhere 粘贴:

export NMEM_API_URL="https://<your-url>"export NMEM_API_KEY="nmem_..."

- 点击 Fill URL + key

- 点击 Save,再点击 Test connection

完整流程(Quick link 与 Cloudflare 账号两种模式):随处访问 Mem。

下载

Nowledge Mem Exchange captures memories from your AI conversations across 13+ platforms. It runs in a native Chrome SidePanel alongside your chats and can auto-capture valuable insights or backup full threads.

Browser extension to capture conversations from Web AI chat services.

Browser extension to capture conversations from Web AI chat services.

该扩展还支持将任何对话线程下载为 .md 文件,用于归档或分享。

对话线程文件导入

将其他 AI 工具导出的对话文件上传到 Nowledge Mem。

AI 对话发现(自动同步)

直接在应用中发现并导入本地 AI 编程助手会话:

| 客户端 | 同步方式 | 入口 |

|---|---|---|

| Claude Code | 自动发现 + 增量同步 | 对话线程 → 导入 → 查找 AI 对话 |

| Cursor | 自动发现 + 增量同步 | 对话线程 → 导入 → 查找 AI 对话 |

| Codex | 自动发现 + 增量同步 | 对话线程 → 导入 → 查找 AI 对话 |

| OpenCode | 自动发现 + 增量同步 | 对话线程 → 导入 → 查找 AI 对话 |

批量导入(一次多个对话线程)

从单个导出文件批量导入所有对话:

| 来源 | 文件格式 | 如何导出 |

|---|---|---|

| ChatGPT | chat.html | 设置 → 数据控制 → 导出数据 |

| ChatWise | .zip(包含 JSON 文件) | 从 ChatWise 应用导出所有聊天 |

单个对话线程导入

导入单个对话:

| 来源 | 文件格式 | 备注 |

|---|---|---|

| Cursor | .md | 从 Cursor 导出对话 |

| ChatWise | .html | 单个聊天 HTML 导出 |

| 通用 | .md | 任何带有用户/助手格式的 markdown |

Bring your existing knowledge from other apps into Nowledge Mem by importing conversation files.

How It Works

Navigate to Threads

Go to the 'Threads' section from the main sidebar.

Start the Import

Click the 'Import Thread' button to open the file.

Select & Preview

Choose your exported file & select messages to import.

Supported Formats

Bulk Import (Multiple Threads)

ChatGPT Data Export

chat.html from Settings → Data controls → Export data

ChatWise ZIP Export

Export all chats as .zip from ChatWise app

Single Thread Import

Cursor Exports

Cursor .md exported conversation files.

ChatWise HTML

Single conversation .html export.

Generic Markdown

Cursor exported compatible .md files.

We are working hard to support more import sources. For any tools you'd love to see integrated, please let us know.

面向开发者的自定义导入工具:

深度集成

以下工具提供一键设置、内置技能或原生记忆支持。DeepChat 和 LobeHub 将 Nowledge Mem 作为内置记忆选项。

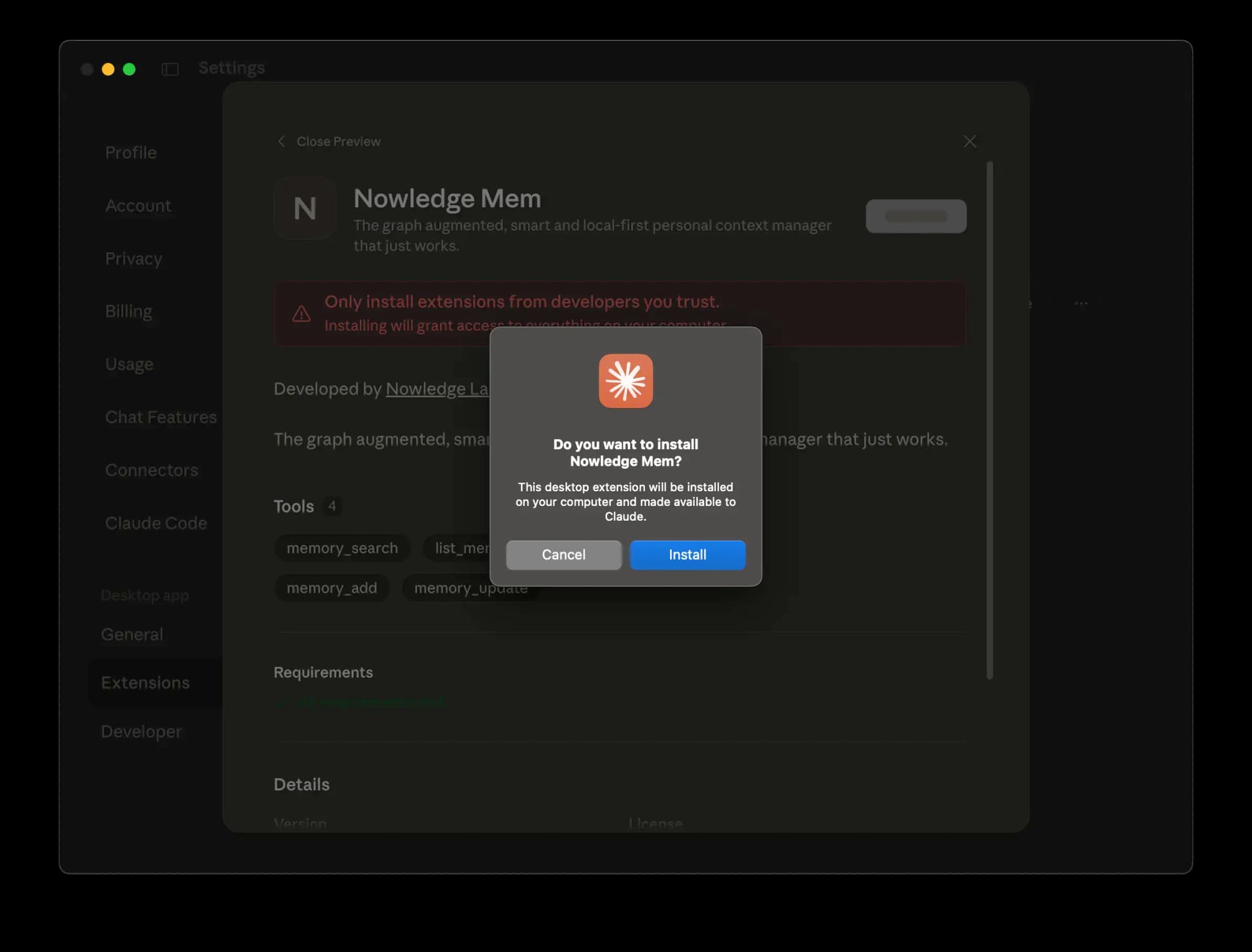

Claude Desktop

一键扩展,让 Claude Desktop 直接读写你的 Nowledge Mem 知识库。

下载扩展

安装扩展

确保你的系统已安装 Python 3.13。

打开 Terminal.app 并运行以下命令:

which brew || /bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

python3.13 --version || /opt/homebrew/bin/brew install python@3.13- 双击从浏览器下载区域下载的

claude-dxt.mcpb文件 - 在安装对话框中点击 安装 按钮

- 重启 Claude Desktop 应用

你现在可以在对话期间随时让 Claude 将洞察保存到 Nowledge Mem、更新现有记忆或搜索你的知识库。

注意,如果你无法在 Claude Desktop 中启用 Mem,请通过

tail -n 20 -F ~/Library/Logs/Claude/mcp*.log检查日志并与我们分享。

Claude Code

技能兼容

Claude Code 支持技能 - 安装插件即可获得内置自主行为。无需系统提示或 MCP 配置。

通过 CLI 插件直接在 Claude Code 中使用 Nowledge Mem。插件自动:

- 搜索知识库获取相关上下文

- 在关键发现时建议提炼

- 按请求保存会话

安装 Claude Code 插件

安装 Nowledge Mem 插件,让 Claude Code 自动搜索、保存和记录关键发现。插件通过 nmem CLI 与知识库交互。参见:Claude Code 插件文档。

# 添加 Nowledge 社区市场

claude plugin marketplace add nowledge-co/community

# 安装 Nowledge Mem 插件

claude plugin install nowledge-mem@nowledge-community先决条件:插件需要 nmem CLI。安装方法:

# 选项 1(推荐):使用 uvx(无需安装)

curl -LsSf https://astral.sh/uv/install.sh | sh

uvx nmem --from nmem-cli --version

# 选项 2:使用 pip 安装

pip install nmem-cli注意:在 Windows/Linux 上安装了 Nowledge Mem 桌面应用时,nmem 已内置。在 macOS 或远程服务器上,使用 uvx 或手动安装。

更新插件:获取最新版本:

claude plugin marketplace update

claude plugin update nowledge-mem@nowledge-community

# 重启 Claude Code 以应用更改使用方法

在 Claude Code 聊天中使用 Nowledge Mem 的三种方式:

斜杠命令(快速访问)

直接输入这些命令:

/save- 保存当前会话到 Nowledge Mem/sum- 将对话洞察提炼成记忆/search <查询>- 搜索你的知识库

自然语言

-

说 "保存此会话" 或 "保存这个对话"

-

Claude 会自动运行

nmem t save --from claude-code -

说 "提炼这个对话" 或 "保存关键洞察"

-

Claude 会分析并使用

nmem m add创建结构化记忆

自主(通过技能)

插件包含四个自动运行的技能:

- Read Working Memory: 在会话开始和上下文压缩后加载每日简报

- Search Memory: 引用过去工作时自动搜索

- Distill Memory: 在突破时刻建议提炼

- Save Thread: 根据明确请求保存会话

生命周期 Hooks

插件包含 Claude Code hooks 用于自动生命周期管理:

| 事件 | 触发器 | 操作 |

|---|---|---|

SessionStart(启动) | 新会话开始 | 注入 Working Memory 简报 |

SessionStart(压缩) | 上下文压缩后 | 重新注入 Working Memory 并提示 Claude 保存重要发现 |

Hooks 自动运行。Working Memory 在启动和压缩后注入上下文,Claude 始终了解你的当前优先事项。压缩后会提示 Claude 通过 nmem m add 保存重要发现。

自主知识捕获

创建自定义智能体,在工作中自动捕获洞察、决策和学习。

查看完整示例:AGENTS.md

此示例展示了如何:

- 创建用于自主知识捕获的记忆守护智能体

- 使用 5 种记忆类别(insight、decision、fact、procedure、experience)

- 应用重要性评分(0.1-1.0)

- 使用

--source-thread将记忆链接到源对话线程 - 将智能体与 hooks 结合以实现全面的会话管理

AGENTS.md 文件遵循通用的 agents.md 标准,可与任何 AI 编程智能体配合使用。

Codex CLI

技能兼容

Codex 支持自定义提示 - 安装它们以获得内置斜杠命令。无需 MCP 配置。

通过 nmem CLI 和自定义提示在 Codex 中使用 Nowledge Mem。

安装 nmem CLI

Codex 提示使用 nmem CLI 命令。安装方法:

# 选项 1(推荐):使用 uvx(无需安装)

curl -LsSf https://astral.sh/uv/install.sh | sh

uvx --from nmem-cli nmem --version

# 选项 2:使用 pip 安装

pip install nmem-cli注意:在 Windows/Linux 上安装了 Nowledge Mem 桌面应用时,nmem 已内置。在 macOS 或远程服务器上,使用 uvx 或手动安装。

安装自定义提示

安装自定义提示,添加斜杠命令来保存会话和提炼洞察。

安装:

全新安装:

curl -fsSL https://raw.githubusercontent.com/nowledge-co/community/main/nowledge-mem-codex-prompts/install.sh | bash更新安装:

curl -fsSL https://raw.githubusercontent.com/nowledge-co/community/main/nowledge-mem-codex-prompts/install.sh -o /tmp/install.sh && bash /tmp/install.sh --force && rm /tmp/install.sh在 Codex 聊天中使用:

斜杠命令

直接输入这些命令:

/prompts:read_working_memory- 加载每日 Working Memory 简报获取上下文/prompts:save_session- 使用nmem t save --from codex保存当前会话/prompts:distill- 使用nmem m add提炼洞察

或输入 / 并搜索 "memory"、"save" 或 "distill" 找到它们。

故障排除

- "Command not found: nmem" → 使用

uvx --from nmem-cli nmem --version或用pip install nmem-cli安装 - "Command not found: uvx" → 用

curl -LsSf https://astral.sh/uv/install.sh | sh安装 uv,然后使用uvx --from nmem-cli nmem --version安装 nmem - 会话未列出 → 确保你在正确的项目目录中

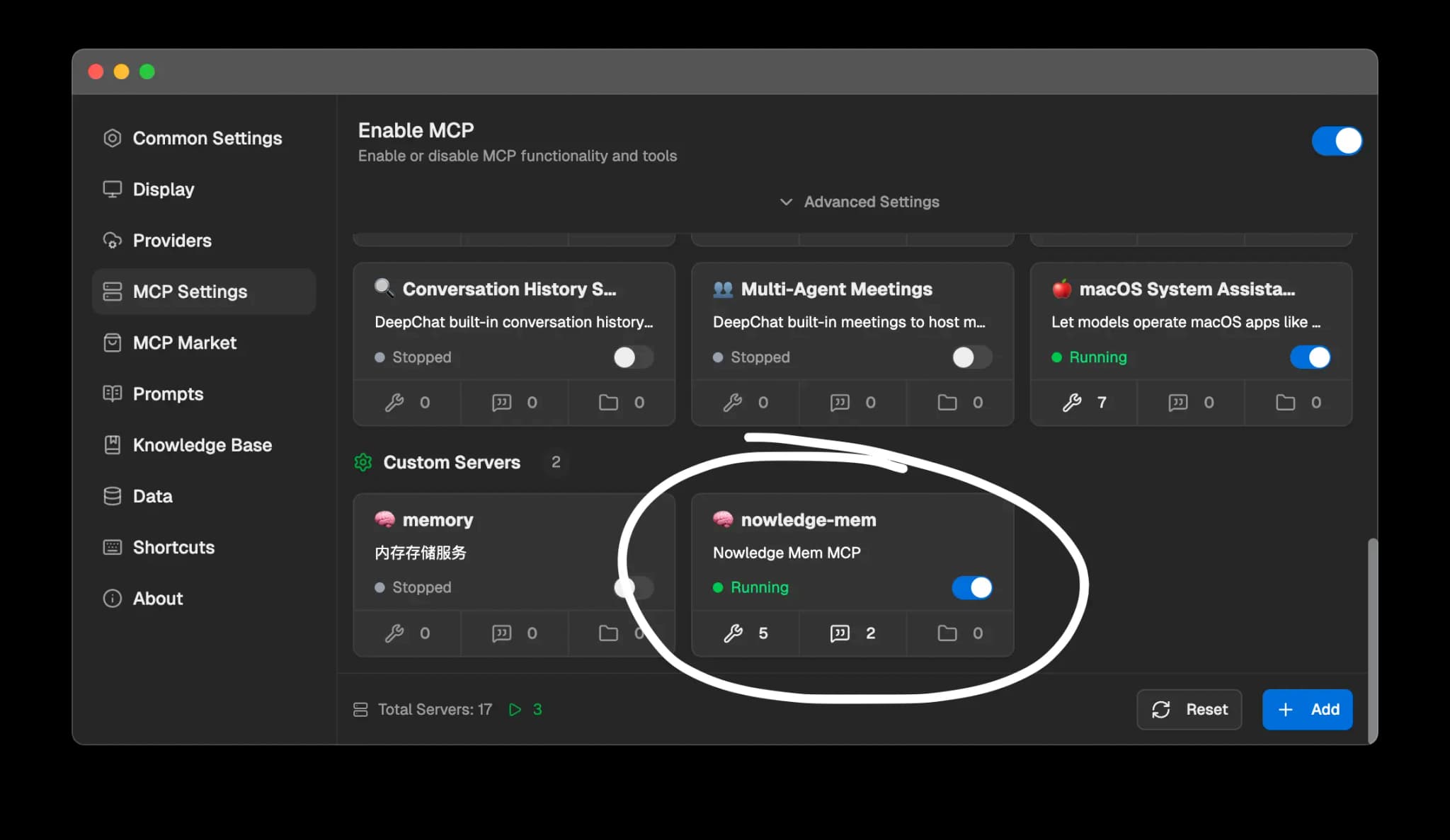

DeepChat

DeepChat 内置 Nowledge Mem 集成,一键开启记忆保存和搜索。

在 DeepChat 中启用 MCP

在 设置 > MCP 设置 下切换开关

启用 Nowledge Mem

在 自定义服务器 下切换 nowledge-mem 开关

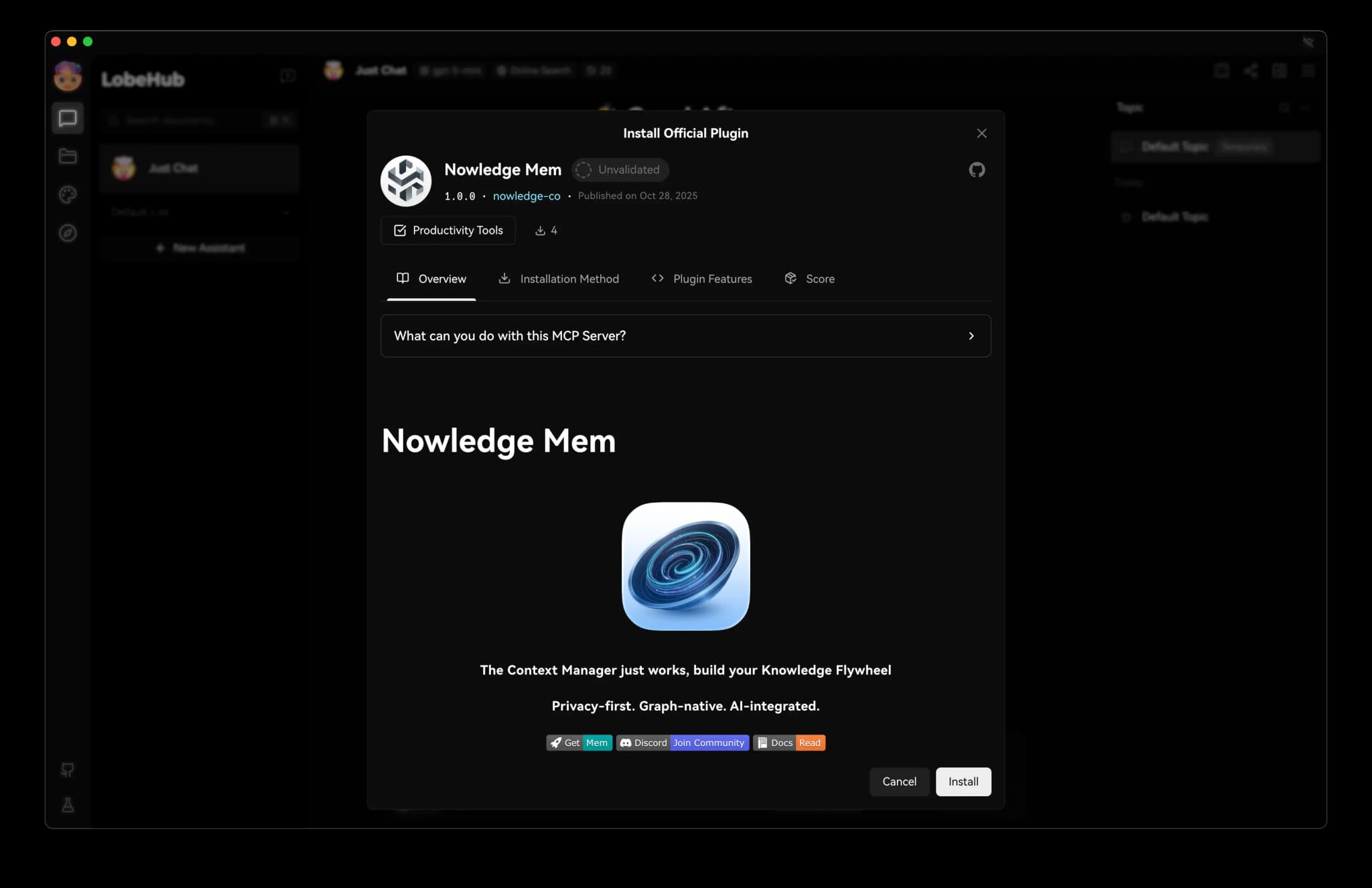

LobeHub

LobeHub(原 LobeChat)内置 Nowledge Mem 集成,一键开启记忆保存和搜索。

点击 安装 按钮安装 Nowledge Mem LobeHub 插件。

OpenClaw

OpenClaw 是一个开源 AI 智能体框架。装上这个插件,你的 OpenClaw 会拥有跨会话的持久记忆——它记住你上周说的话,记住你几个月前写入文档的决策,也记住你今天的工作重心。

源码:community/nowledge-mem-openclaw-plugin

安装插件

openclaw plugins install @nowledge/openclaw-nowledge-mem在 ~/.openclaw/openclaw.json 中启用

{

"plugins": {

"slots": {

"memory": "openclaw-nowledge-mem"

},

"entries": {

"openclaw-nowledge-mem": {

"enabled": true,

"config": {

"autoRecall": true,

"autoCapture": false,

"maxRecallResults": 5

}

}

}

}

}重启 OpenClaw,运行 openclaw nowledge-mem status 确认连接正常

你可以做什么:

/remember任何内容,新会话照样记得- 问"上周二我在做什么",AI 列出那天的活动和决策

- 追溯一个想法的演化过程——哪些文档影响了它、它怎么随时间变化

- 每天早上 AI 自动读取今日简报(Working Memory),开口就在状态里

- 斜杠命令:

/remember、/recall、/forget

5 分钟配置步骤与完整功能说明:OpenClaw × Nowledge Mem

Alma

Alma 插件,提供持久化记忆工作流。

源码:community/nowledge-mem-alma-plugin

克隆插件、安装依赖,并复制到 Alma 本地插件目录

git clone https://github.com/nowledge-co/community.git

cd community/nowledge-mem-alma-plugin

npm install

mkdir -p ~/.config/alma/plugins/nowledge-mem

cp -R . ~/.config/alma/plugins/nowledge-mem重启 Alma

插件提供:

- 工具集:记忆 query/search/store/show/update/delete + 线程 search/show/create/delete + Working Memory

- 命令面板动作:状态检查、搜索、保存记忆、读取 Working Memory、保存当前线程

- 自动回忆 hook:每个线程首条外发消息注入 Working Memory + 相关记忆

- 可选自动捕获 hook:应用退出时保存当前线程

- 本地运行时:使用

nmemCLI(回退uvx --from nmem-cli nmem)

Raycast

从 Raycast 搜索你的知识库。四个命令:

源码:community/nowledge-mem-raycast

| 命令 | 功能 |

|---|---|

| 搜索记忆 | 语义搜索,显示相关度分数,可复制内容或标题 |

| 添加记忆 | 保存记忆,设置标题、内容和重要性 |

| Working Memory | 查看每日简报 |

| 编辑 Working Memory | 内联编辑 ~/ai-now/memory.md,更改会被所有连接的 AI 工具尊重 |

Raycast Store(即将上线):Store 提交合并后,在 Raycast Store 中搜索 "Nowledge Mem" 即可安装。

从源码安装(现在可用):

git clone https://github.com/nowledge-co/community.git

cd community/nowledge-mem-raycast

npm install && npm run dev需要 Nowledge Mem 在本地运行。扩展通过 localhost:14242 的 HTTP API 进行搜索和创建记忆,并从 ~/ai-now/memory.md 读取 Working Memory。

LLM 友好文档

本文档站的每一页都可以作为干净的 Markdown 提供给 AI 智能体和 LLM。在请求任何文档页面时添加 Accept: text/markdown 请求头,即可获得 Markdown 而非 HTML:

# 获取任意文档页面的 Markdown

curl -H "Accept: text/markdown" https://mem.nowledge.co/docs

curl -H "Accept: text/markdown" https://mem.nowledge.co/docs/getting-started

curl -H "Accept: text/markdown" https://mem.nowledge.co/docs/integrations也提供专用端点:

| 端点 | 返回内容 |

|---|---|

/llms-full.txt | 所有文档页面合并为一个文件 |

/llms.mdx/docs/<slug> | 单页 Markdown(例如 /llms.mdx/docs/getting-started) |

无需认证。

API 集成

RESTful API,完整访问你的知识库。

命令行界面 (CLI)

nmem CLI 提供终端下的知识库访问,面向开发者和 AI 智能体。

安装

| 平台 | 安装 |

|---|---|

| macOS | 设置 → 偏好设置 → 开发者工具 → 安装 CLI |

| Windows | 随应用自动安装 |

| Linux | 包含在 deb/rpm 包中 |

快速入门

# 检查连接

nmem status

# 搜索记忆

nmem m search "项目笔记"

# 列出最近记忆

nmem m

# 创建记忆

nmem m add "重要洞察" --title "项目学习"

# 搜索对话线程

nmem t search "架构"

# 通过 CLI 保存 Claude Code/Codex 会话

nmem t save --from claude-code

nmem t save --from codex -s "完成工作的摘要"

# 从内容创建对话线程

nmem t create -t "会话笔记" -c "关键讨论要点..."

# 从文件创建对话线程

nmem t create -t "会议笔记" -f notes.mdAI 智能体集成

CLI 设计用于 AI 智能体工作流程,支持 JSON 输出:

# 获取 JSON 输出用于解析

nmem --json m search "API 设计"

# 链接命令

ID=$(nmem --json m add "笔记" | jq -r '.id')

nmem --json m update "$ID" --importance 0.9

# 多消息对话线程创建

nmem t create -t "会话" -m '[{"role":"user","content":"问"},{"role":"assistant","content":"答"}]'命令参考

| 命令 | 别名 | 描述 |

|---|---|---|

nmem status | 检查服务器连接 | |

nmem stats | 数据库统计 | |

nmem memories | nmem m | 记忆操作 |

nmem threads | nmem t | 对话线程操作 |

完整文档

完整的 CLI 文档,运行 nmem --help 或查看 GitHub 上的 CLI 参考。

展示你的集成

用 API 或 CLI 做了什么?在 Github Issues、Discord 或 邮件 中分享。优秀项目可获得 Pro 许可证。

下一步

设置有问题?查看故障排除指南: